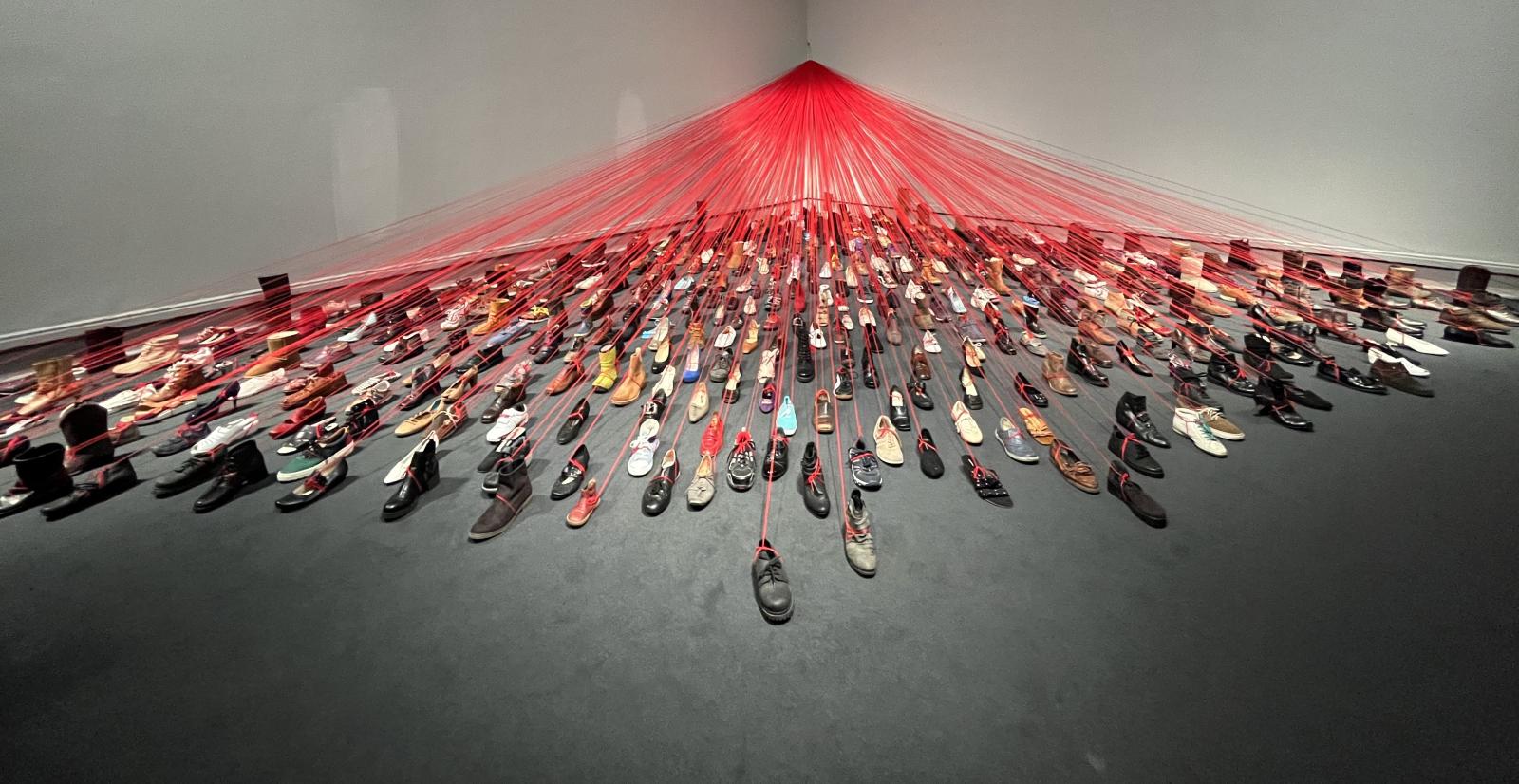

Crediti: Chiharu Shiota - Over the Continents - 2011, foto di Luca Carra.

Lo scorso aprile la rivista online MIT Technology Review ha dedicato una sua Serie a quello che ha coraggiosamente definito "colonialismo dell'Intelligenza artificiale" (AI Colonialism). L’articolo introduttivo, dal titolo abbastanza significativo (Artificial intelligence is creating a new colonial world order), a firma Karen Hao (la curatrice della serie), ha come sottotitolo A MIT Technology Review series investigates how AI is enriching a powerful few by dispossessing communities that have been dispossessed before, indicando una continuità fra vecchie e nuove forme di sfruttamento, piuttosto imbarazzante per i paladini dell’innovazione.

Curiosamente, il racconto inizia durante il viaggio di nozze dell’autrice nel Sud della Spagna, dove i ricordi dello sfruttamento coloniale che rese ricche le città oggi considerate gioielli d’arte sono ancora evidenti, a chi li voglia vedere (l'esempio è il modernismo catalano che ebbe il massimo esponente in Gaudì, che costruì fastose magioni per le famiglie arricchite con lo sfruttamento delle piantagioni di zucchero delle colonie americane). Hao vede un parallelo fra questi simboli dell’estrazione di valore del colonialismo e lo sviluppo globalizzante dell’industria dell’AI. Che non si appropria della terra come facevano i conquistadores ma, mossa dalla stessa ricerca di profitto, tende a espandere la sua area di influenza: più acquirenti per i propri prodotti, più esseri umani controllati dai propri algoritmi, significano maggiori risorse che si possono estrarre dalle loro attività.

Non è lo sfruttamento del lavoro basato sullo schiavismo di massa, ma lo sviluppo di nuove forme di sfruttamento di un lavoro a buon prezzo e precario, spesso nel Sud del mondo, basato sull’idea implicita che queste persone non meritano (o non hanno bisogno di) salari decorosi e stabilità economica. Le comunità così impoverite e sfruttate sono in molti casi le stesse che hanno subito l’oppressione coloniale.

La serie si propone di affrontare l’impatto sociale dell’AI, ma anche di prefigurare come le cose potrebbero andare diversamente: una “decolonial AI” che riporti il potere dal Nord al Sud del mondo…Mica una cattiva idea, ma neanche roba da poco. In quest’ottica i quattro articoli che seguono presentano i due aspetti: i primi due parlano di due casi di sfruttamento basato sulle nuove tecnologie, gli altri due raccontano esempi di organizzazione e di lotta per rimpadronirsi di questi strumenti. Vale la pena leggerli in extenso, perché contengono un sacco di informazioni interessanti. Qui li riassumeremo brevemente.

La sorveglianza digitale in Sudafrica

Il primo (South Africa's private surveillance machine is fueling a digital apartheid) racconta di come un sobborgo di Soweto (Johannesburg, Sudafrica) sia il terreno per una sperimentazione dei modelli di sorveglianza digitale che potranno servire all’industria globale della sorveglianza per esportarla altrove. Il cocktail è stato uno sviluppo del cablaggio in fibra (prima era impossibile elaborare e codificare le enormi montagne di dati necessarie) e un alto tasso di criminalità: le industrie hanno fiutato l’affare, sono arrivate con le ultime tecnologie di AI (di origine principalmente cinese ed europea) e hanno rapidamente creato un sistema centralizzato e totalmente privato di sorveglianza di massa: l’azienda Vumacan, che gestisce la rete nazionale di videocamere, ne ha più di 5000 a Johannesburg. Le telecamere non sono installate nell’abitato di Soweto (sono poveri e nessuno paga per l’istallazione, e poi la criminalità “interna” non interessa), ma compaiono al confine fra il ghetto e le zone più affluenti, e aumentano mano a mano che si va verso i quartieri centrali.

Anche se l’azienda dichiara di non avere al momento in opera sistemi di riconoscimento facciale, molte telecamere sono già di tipo sofisticato compatibili con questo uso. Per ora, l’impiego principale dichiarato è quello del riconoscimento delle targhe delle auto, in seguito a segnalazioni di furti o di utilizzo in rapine, ma vista la dipendenza dall’auto per gli spostamenti nella zona di Johannesburg, questo vuol dire poter seguire e identificare praticamente chiunque (in realtà il riconoscimento facciale è in pieno sviluppo anche in Sudafrica, ed è stato utilizzato, con tecniche più rudimentali, da compagnie private, per esempio nel caso delle proteste degli studenti neri in alcune università). I servizi di Vumacan sono acquistati dalle imprese di sicurezza private, che dominano la situazione come retaggio dei tempi dell’apartheid e come conseguenza della limitatissima presenza di forze di polizia pubbliche (in Sudafrica ci sono 1.100 stazioni di polizia con poco più di 180.000 agenti, contro 11.372 compagnie di sicurezza accreditate con 564.540 guardie private). La polizia, in alcuni casi almeno, si appoggia a questi servizi privati nella ricerca di presunti criminali.

In un certo senso, la rete di telecamere sta ricreando l’equivalente digitale dei passbooks o passaporti interni, il sistema che nell’epoca dell’apartheid limitava i movimenti dei neri nelle enclaves bianche. E parlare di continuità con il vecchio colonialismo ha un senso a Soweto, che sorge sulle macerie di rifiuti tossici delle miniere d’oro.

Il Sudafrica rappresenta un terreno di sperimentazione e alcune compagnie stanno già tentando di vendere i loro prodotti, soprattutto nell’analisi dati, a clienti negli USA: i bassi salari consentono di offrire servizi a prezzi competitivi, e così lo sfruttamento è doppio.

Qualcuno ha posto il problema se questi soldi non sarebbero meglio utilizzati per fornire servizi agli abitanti dei ghetti, alleviando così la povertà che alimenta la criminalità: ma per le compagnie questa è un'opportunità per fare profitti.

L'AI che sfrutta la manodopera dov'è più debole

Il secondo articolo (How the AI industry profits from catastrophe) è ancora più centrale rispetto al tema proposto.

Il mercato del data labeling, cioè l’annotazione d'immagini o sequenze vocali da immettere in sistemi di deep learning per consentire il loro riconoscimento, è in continua crescita. Sono compiti da eseguire manualmente, e lo sviluppo vorticoso del settore ha creato la richiesta di grandi quantità di lavoro a basso costo. Si stima che i valore di mercato di questo “lavoro fantasma” raggiungerà i 13.7 miliardi di dollari entro il 2030. E allora le aziende vanno a caccia nei posti giusti. Un esempio è il Venezuela. L’articolo è la storia di una giovane venezuelana, ora emigrata in Colombia. Studiava per diventare ingegnera, con la prospettiva di un buon posto nell’industria petrolifera. Aveva cominciato a fare questi lavoretti “gig” per una piattaforma; poi la crisi ha devastato il paese, e il lavoretto temporaneo è diventata l’unica possibilità di avere un reddito. Ma il prezzo è salato: le piattaforme si sono buttate su paesi come il Venezuela perché sanno che possono prendere la gente per la gola: hanno ridotto i compensi, bloccano gli account, chiudono i programmi in una gara frenetica a offrire servizi sempre più a basso costo alle aziende di Silicon Valley (e non solo, vedi sotto). E il Venezuela può diventare il primo passo nella ricerca di paesi ancora più deboli, per verificare fin dove si può scendere nei compensi per questi servizi.

Anche qui, il paragone è con il colonialismo storico: come un tempo, gli imperi (questa volta non Stati, ma megacompanies) estraggono profitto dallo sfruttamento del lavoro di paesi vulnerabili, depredandoli delle risorse che potrebbero garantire il loro sviluppo.

L’articolo è molto lungo, pieno di dati interessanti e va letto per intero. Qui riassumerò solo uno degli aspetti della questione, che mi pare particolarmente istruttivo.

Uno dei fattori che ha contribuito all’esplosione di questo fenomeno è la corsa all’auto a guida autonoma, e i responsabili pare siano i costruttori di auto europei che, spaventati dall’attivismo delle aziende americane, hanno deciso di investire miliardi in questo settore, spingendo per raggiungere nuovi livelli nell’affidabilità delle annotazioni. Come tutti i modelli di AI basati sul deep learning, le auto a guida autonoma richiedono milioni, anzi miliardi di esempi annotati per imparare. Si tratta di ore di registrazioni video che devono essere analizzate e annotate fotogramma per fotogramma, per riconoscere auto, segnali, alberi, pedoni, bidoni della spazzatura e ogni cosa che l’auto può incontrare. Il problema rispetto agli usi abituali dell’AI in campo commerciale è che qui la precisone deve essere altissima. Qualche errore di troppo può decidere fra vita o morte. Mechanical Turk (MTurk), la piattaforma di Amazon, è stata per circa dieci anni la protagonista nel campo dei piccoli lavori pagati una miseria. Ma MTurk era una piattaforma generalista, e non garantiva una elevata qualità di base.

Una nuova generazione di piattaforme è entrata nel gioco, in grado di promettere accuratezza nel labelling al 99%. Una delle più potenti è ScaleAI. Fondata nel 2016 da uno studente diciannovenne del MIT, ha raccolto rapidamente decine di migliaia di “lavoratori dell’annotazione” ed è riuscita a stipulare contratti con importanti multinazionali. Ora è valutata 7.3 miliardi di dollari e ha ottenuto un grosso appalto dal Ministero della Difesa USA. Per garantire altissima affidabilità (e anche velocità) a prezzi stracciati, ovviamente il segreto è di cercare, a livello globale, la manodopera dove è più debole. Inizialmente si è rivolta a Filippine e Kenia, ma poi, seguendo la spinta di altre aziende, ha trovato nel Venezuela quella che è la miscela giusta: un costo del lavoro fra i più bassi e un buon livello di istruzione e di infrastrutture. Nel 2019 ha lanciato una campagna sui social promettendo grossi guadagni, formazione e avanzamenti retributivi.

In realtà, l’articolo documenta molto bene i soprusi a cui sono sottoposti i lavoratori: riduzioni arbitrarie dei compensi, disfunzioni delle piattaforme scaricate sugli operatori, ritardi o omissioni dei pagamenti, punizioni arbitrarie. In ogni caso, un portavoce di Scale ha dichiarato che il compenso orario medio per il Venezuela è di 0.90 €….

Indonesia, la lotta agli algoritmi

Gli altri due articoli descrivono due esempi di risposta e di auto-organizzazione dei lavoratori. Il primo dei due (The gig workers fighting back against the algorithms) racconta la storia dei guidatori di mototaxi di Jakarta della società Gojek, che portano i passeggeri sul sellino posteriore o consegnano pacchi e cibo. Poiché la società non mette a loro disposizione spazi per le pause, servizi igienici e ricarica dei telefoni, si sono creati un loro posto di ristoro e di aggregazione. Questi posti si collegano a una tradizione indonesiana dove, anche prima dell’arrivo dei lavori controllati dagli algoritmi, i guidatori informali di mototaxi avevano punti di raduno per scambiarsi informazioni e consigli. Tutto era informale, un po’ caotico – come il caos del traffico di Jakarta - e non sempre efficiente per chi aveva bisogno di un passaggio (per esempio, molti tassisti rifiutavano gli spostamenti troppo lunghi), finché è arrivata la piattaforma che ha organizzato il servizio – e imposto le sue regole.

La nuova organizzazione del servizio (chiamate via App, prezzi predeterminati), piacque molto agli utilizzatori e anche gli investitori internazionali, che vedevano un’opportunità di crescita in un paese che non presentava, almeno in prima istanza, problemi di conflitti di lavoro organizzati. All’inizio piacque anche ai drivers. Ojek spinse nella direzione di accettare il lavoro a tempo pieno con lei o di andarsene, con una politica di attraenti bonus e la promessa di triplicare il loro precedente guadagno. Ma in cambio di un po’ di guadagni, i drivers persero la loro autonomia e si trovarono in balia dell’algoritmo e obbligati all’obbedienza. L’aumento del numero dei lavoratori portò alla riduzione delle paghe; la competizione con altri fornitori portò all’aumento delle ore lavorate a parità di compenso. Un intervistato paragona la situazione alla dipendenza delle droghe: “la paga cala, ma non hai altre opzioni, e diventi sempre più dipendente”. Gli arbitrii sono numerosi, e se sei malato rischi di essere messo da parte. In risposta, alcuni drivers hanno creato una comunità online che connette i lavoratori, passa le informazioni, avvisa di possibili truffe, informa su come è possibile migliorare i guadagni, aiuta in caso di incidenti. In realtà di reti di questo tipo ce ne sono moltissime in Indonesia. Durante la pandemia, queste organizzazioni informali hanno svolto funzioni di mutuo soccorso, distribuendo aiuti e pacchi alimentari fra i lavoratori in maggiore difficoltà. Queste comunità sono anche importanti per le guidatrici donne (una minoranza), che possono segnalare quando sono in zone a rischio. La solidarietà si estende al territorio: i campi base sono accettati dalle comunità locali, diventano punti di riferimento per tutti. Ed è su questa estesa e stratificata rete di connessioni sociali, su questo senso di comunità, che i drivers sono riusciti ad impostare una vera e propria battaglia di resistenza all’algoritmo.

Si è cominciato con piccoli trucchi, largamente condivisi, per rendere il lavoro più facile, come “persuadere” l’algoritmo a comportarsi meglio: un driver aveva un account che gli mandava principalmente ordini di consegna cibo, più pesanti nella stagione delle piogge: avendo capito che l’algoritmo impara le preferenze del driver, ha tenuto duro per una settimana rifiutando tutte le commesse di consegna cibo e accettando solo quelli di servizio taxi, e alla fine l’algoritmo si è adeguato.

I più esperti tecnicamente hanno sviluppato un intero ecosistema di app non autorizzate che aiutano i drivers a modificare i loro account. A volte sono molto semplici, ma riducono la dipendenza dagli ingegneri di Gojek, come modificare l’interfaccia perché sia più leggibile o accettare i lavori automaticamente. Ma il più popolare (ha 1 milione di download) è un’app che “frega” il GPS del telefono, e fa risultare che il driver sta lavorando anche quando si riposa, eliminando le punizioni o consentendo di essere promossi a lavori più remunerativi. Se Gojek pesca un driver che usa queste app lo sospende, e questo ha scatenato una “guerra delle app”, dove ciascuna delle due parti sviluppa sistemi sempre più complessi per combattere l’altra. Gojek ora manda suoi rappresentanti ai campi base per discutere con i drivers.

Questa capacità del movimento dei drivers di crescere e di accumulare consensi e spazio politico li ha spinti a puntare su cambiamenti più radicali. Diffondono le loro proteste quando le app vengono modificate in maniera sfavorevole e avanzano richieste più incisive. Recentemente, dopo una campagna publica, hanno ottenuto di non dover pagare il parcheggio quando consegnano cibo.

Un’intervistatrice ha scritto: “I drivers si sentono molto più forti, attraverso la loro struttura comunitaria, in grado di contrattare con l’azienda in una maniera sconosciuta ai guidatori di Uber e Lyft negli USA”. Ed è questo senso di comunità che distingue i drivers di Jakarta da molti gig workers nel mondo. La gestione algoritmica mette i lavoratori l’uno contro l’altro, impedendo i rapporti personali e la costruzione delle basi per una mobilitazione. Questo, a parere di molti studiosi, indica come le società delle piattaforme riproducono il comportamento degli imperi coloniali usando strumenti di gestione delle risorse umane per sorvegliare e sfruttare ampie fasce di lavoro a buon mercato. L’esperienza dei drivers di Jakarta potrebbe indicare una inversione di tendenza.

Anche perché, per concludere, i lavoratori del settore sono stati in grado di usare eventi internazionali, che attiravano sull’Indonesia l’attenzione internazionale, per minacciare scioperi e ottenere dal Governo un riconoscimento legale, con la prospettiva di ottenere una regolamentazione seria delle loro condizioni di lavoro. Una capacità quindi di unire l’agitazione di base ad una prospettiva di incidere sul piano istituzionale. Alcune organizzazioni formali puntano ad una legge nazionale, che stabilisca standard minimi e garanzie per questi lavoratori.

La controffensiva padronale non è tardata, con sanzioni più severe sulle app non autorizzate e con il tentativo di “comprare” alcuni esponenti del movimento con facilitazioni e lavori extra. La battaglia non è finita; ma la capacità di usare una forte infrastruttura sociale contro la frammentazione indotta dall’uso autoritario della tecnologia è la base del successo di questa esperienza: “Noi comunque continueremo a ridurre il peso del nostro lavoro, a distribuire cibo, ad aiutare chi fora una gomma, a raccogliere fondi per chi va in ospedale. La solidarietà è molto, molto forte” dice un lavoratore.

Un'AI al di fuori dei meccanismi di profitto

Il quarto articolo (A new vision of artificial intelligence for the people) descrive un’esperienza di sviluppo di AI “alternativa”, partita dalla base, per difendere le culture locali.

In un paesino della Nuova Zelanda, una coppia che gestisce una radio maori, Te Hiku, ha acquistato a metà prezzo un computer di ultima generazione e ha iniziato un esperimento di rivitalizzazione della lingua maori, il te reo. Il progetto tocca un tasto sensibile del rapporto fra AI e raccolta dei dati. Sulla spinta del principio “sempre di più”, i modelli ottenuti dal mettere insieme dati da intere popolazioni hanno penalizzato le comunità marginalizzate, anche se queste sono sovente le più soggette all’impatto dei cambiamenti tecnologici.

E questo ha fatto dire a molti studiosi che siamo di fronte a un altro esempio di approccio colonialistico: lo sviluppo dell’AI depriva le comunità che non hanno alcun potere di orientare le sue scelte, le stesse già impoverite dagli imperi coloniali. Ciò è particolarmente vero per quanto riguarda il linguaggio. I modelli usati in tutti i servizi, dai motori di ricerca, alla posta, ai social, basati su enormi montagne di dati, rischiano di accelerare l’uniformazione del linguaggio e di causare la perdita delle lingue delle minoranze e delle popolazioni emarginate, con processi di assimilazione forzata.

Per capovolgere questa logica i promotori del progetto hanno sviluppato i loro strumenti di AI per l’analisi del linguaggio e creato un sistema di raccolta, gestione e protezione di dati relativi ai Maori da usare sempre con il consenso della comunità.

Come in molti altri casi, il declino della lingua maori inizia con la colonizzazione: gli inglesi, oltre a imporre la loro lingua come ufficiale, proibirono nell’800 l’insegnamento della lingua nativa. L’inurbamento fece il resto, e la percentuale di maori che parlavano il te reo scese dal 90% al 12%. Solo nel 1987, dopo anni di mobilitazioni e battaglie, il governo riconobbe il te reo come una delle lingue ufficiali, e finanziò la nascita di radio locali che diffondevano la lingua nativa.

La lingua non è solo uno strumento, e preservare una lingua vuol dire preservare una storia culturale: cosa sempre più difficile nell’era digitale. In vent'anni di trasmissioni, la radio aveva accumulato un grosso archivio di registrazioni in te reo, e i proponenti decisero di digitalizzare l’archivio, dopo aver chiesto l’autorizzazione alle comunità maori. Questo voleva dire creare una piattaforma ad hoc, per non mettere i dati sulle piattaforme commerciali. Mano a mano che il progetto andava avanti, si è complicato e arricchito, sempre alla ricerca di soluzioni efficaci e condivise da tutta la comunità: da interviste ai parlanti nativi sopra i novant'anni, alla soluzione dei problemi legati alla trascrizione delle interviste, che ha portato a creare un assistente vocale che insegnasse al computer a parlare te reo, partendo da un'estesa base di frasi lette da nativi. È stato anche lanciato un concorso a premi, per incitare la gente a partecipare: grande successo. A parte i premi, è stata la grande fiducia di tutta la comunità a fare il risultato: in dieci giorni, Te Hiku ha raccolto 310 ore di accoppiamenti discorso-testo da circa 200.000 registrazioni da più o meno 2500 persone. Un’impresa eccezionale. Il sistema di riconoscimento del linguaggio così creato ha un’accuratezza dell’86%; successivamente sono stati sviluppati altri algoritmi per il riconoscimento automatico di frasi in te reo e per dare un feedback in tempo reale sull’accuratezza della pronuncia a chi sta imparando.

Il problema è nella prospettiva: per poter produrre uno strumento utilizzabile da tutti su un telefono cellulare, sarà necessario fare i conti con qualche azienda big tech. Per prepararsi a questa inevitabile sfida, i creatori stanno creando licenze che concedano l’accesso solo a organizzazioni che garantiscano di rispettare le regole della comunità maori, a chiedere il loro consenso e a trasferire alla comunità stessa gli eventuali benefici derivati dall’utilizzo dei prodotti.

Te Hiku ha cominciato anche a lavorare con comunità più piccole del Pacifico, che hanno radici comuni con la lingua maori, ma che rappresentano realtà molto più piccole, con masse di dati molto più limitate. L’obiettivo è “costruire una Fondazione per le lingue del Pacifico”.

L’esempio sta già incoraggiando altri tentativi. In conclusione, si tratta di una dimostrazione che l’AI può essere sviluppata fuori dai meccanismi del profitto, da e per le persone che la potranno utilizzare.