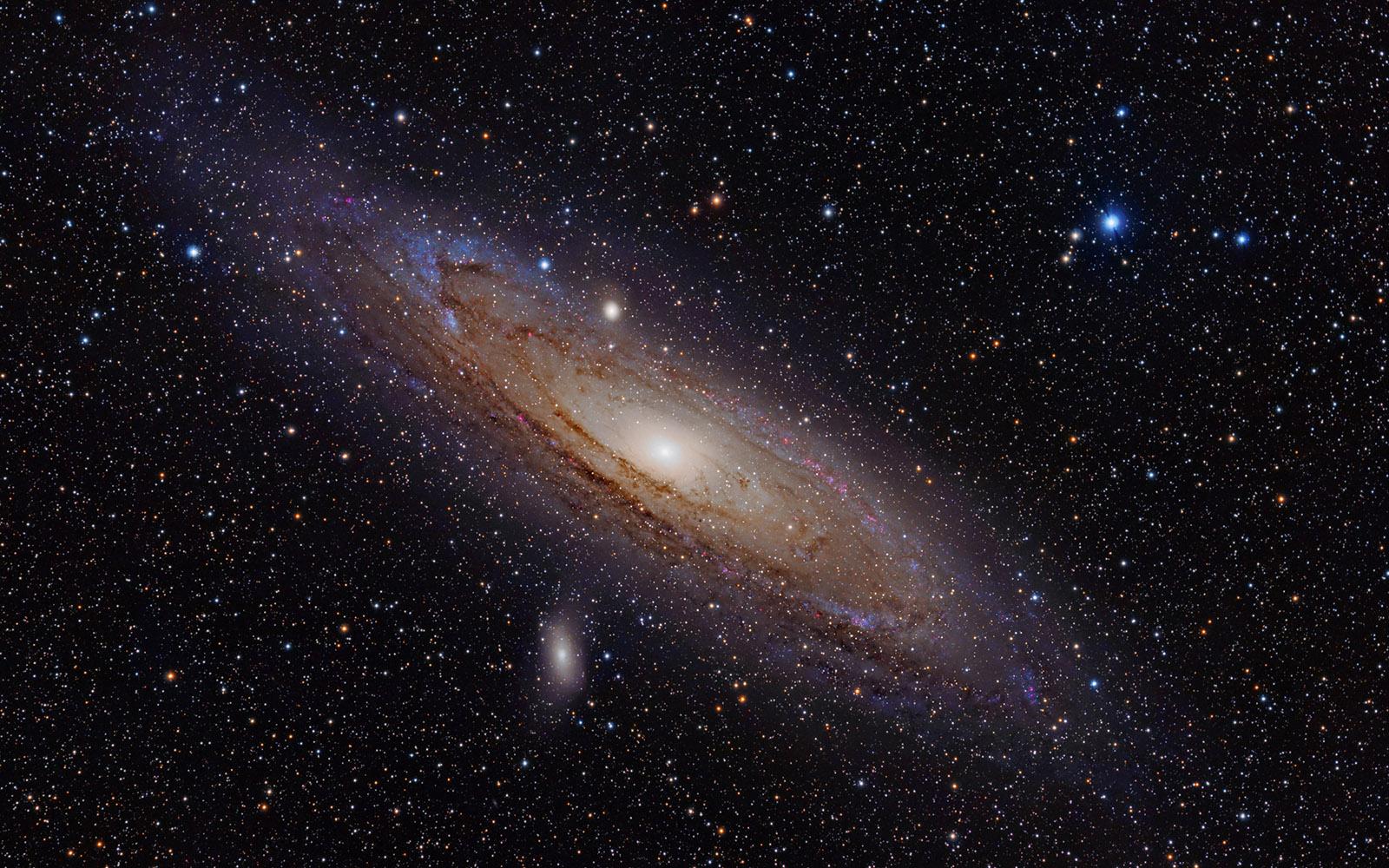

Splendida immagine della Nebulosa di Andromeda (M31). Nel 1925 Edwin Hubble identificò in questa galassia una stella variabile della classe delle Cefeidi e riuscì a determinarne la distanza. La scoperta pose fine al grande dibattito sulla natura delle galassie e indicò che l’Universo era molto più grande della Via Lattea. La cosmologia osservativa muoveva i primi passi. Crediti: Adam Evans

È dalla fine degli anni Trenta che, grazie ai lavori di Georges Lemaître e di Edwin Hubble, sappiamo che il nostro Universo non è un sistema statico. Le osservazioni compiute da Lemaître, astronomo gesuita belga, e da Hubble, astronomo in forza all’Osservatorio di Monte Wilson, indicavano senza ombra di dubbio che, man mano ci si inoltrava nelle profondità dello spazio, le velocità di allontanamento delle galassie – dette velocità di recessione – diventavano sempre più elevate. Era la prova incontrovertibile che il nostro Universo si stava espandendo, uno dei dati osservativi chiave che hanno portato alla formulazione della teoria del Big Bang. Dal punto di vista matematico, la distanza di una galassia e la sua velocità di recessione sono legate da una costante e, fino a qualche anno fa, tale relazione era chiamata legge di Hubble. Oggi, dopo la proposta avanzata dalla IAU lo scorso anno e accettata a grande maggioranza, si preferisce parlare di legge di Hubble-Lemaître.

È evidente come il determinare l’esatto valore di quella costante sia di cruciale importanza in cosmologia. In quel numero, infatti, è racchiusa l’informazione decisiva su quanto sia rapida l’espansione dell’Universo e, dunque, di quanto a ritroso nel tempo si debba andare perché l’Universo fosse tutto racchiuso in quello che Lemaître amava definire “atomo primigenio”.

Il grosso guaio è che differenti e indipendenti metodi di stima della cosiddetta costante di Hubble conducono a valori diversi. Fino a qualche anno fa, considerando i margini di errore, i valori potevano in qualche modo essere compatibili, ma ultimamente il divario è diventato preoccupante e non è più liquidabile come frutto del caso. Inevitabile chiedersi se l’errore stia nei metodi di stima oppure ci sia qualcosa di sbagliato nei modelli cosmologici. Ne parliamo con Amedeo Balbi, cosmologo e divulgatore.

Continuo affinamento

Da quando, alla fine degli anni Trenta, venne proposto il primo valore per la costante di Hubble le cose sono cambiate parecchio. Nello studio in cui Hubble, nel gennaio 1929, annunciava la scoperta di quella fondamentale relazione cosmologica, fissava il valore della costante in oltre 500 km/s per megaparsec. Praticamente, spingendoci nelle profondità del Cosmo, per ogni megaparsec – cioè 3,26 milioni di anni luce – in più di distanza si registrava un aumento della velocità di recessione di oltre 500 km/s. Per quanto avesse comportato uno sforzo osservativo e interpretativo davvero notevole, lo studio presentava due rilevanti punti deboli. Non solo, infatti, riguardava un numero davvero esiguo di galassie (solo 24), ma si basava su misure di distanza che ben presto si dimostrarono poco affidabili.

Con il passare degli anni la felice intuizione di Hubble e Lemaître è sempre stata pienamente confermata, anche se, inevitabilmente, man mano che gli astronomi individuavano nuovi metodi e strategie per spingere sempre più in profondità la determinazione affidabile delle distanze cosmiche ed estendevano l’analisi della recessione a un numero sempre crescente di galassie, il valore della costante di Hubble si allontanava sempre più dalla stima originaria. Per dirla tutta, per almeno cinquant’anni le stime proposte furono davvero molto differenti l’una dall’altra. Alla fine degli anni Cinquanta, per esempio, vi era chi proponeva un valore di 180 km/s/Mpc e chi suggeriva un valore di 75 km/s/Mpc, mentre i primi anni Settanta vedevano contrapporsi coloro che sostenevano un valore di 100 km/s/Mpc e quelli che preferivano un valore di 55 km/s/Mpc. Per chi fosse interessato a questo ping-pong di misurazioni, si segnala questo riassunto della situazione (aggiornato al 2010).

Le ultime misure

A partire dagli anni Novanta, l’impiego del telescopio spaziale – dedicato proprio a Hubble – ha permesso un notevole affinamento delle stime, ma siamo ancora lontani da un valore accettato da tutti. Limitandoci solamente ai tre studi più recenti, possiamo infatti citare le conclusioni del team di Simon Birrer (University of California) e collaboratori, quelle del team di Adam Riess (Johns Hopkins University) e quelle del gruppo di Wendy Freedman (University of Chicago).

Lo studio di Simon Birrer risale al gennaio di quest’anno. Pubblicata su Monthly Notices of the Royal Astronomical Society (qui il preprint pubblicato su arXiv.org), la sua analisi impiega un metodo innovativo basato sullo studio dei cosiddetti quasar doppi e suggerisce per la costante di Hubble il valore di 72,5 km/s/Mpc. Qualche mese più tardi, Adam Riess, premio Nobel 2011 per la scoperta dell’accelerazione dell’Universo e leader del progetto SH0ES (Supernovae, H0, for the Equation of State of Dark Energy), in uno studio pubblicato in maggio su The Astrophysical Journal suggerisce il valore di 74,03 km/s/Mpc. Ancora più recentemente, Wendy Freedman, che per la sua analisi ha impiegato indicatori di distanza differenti (invece delle classiche stelle Cefeidi, una tipologia di particolari stelle variabili, ha usato le stelle giganti rosse) nel suo studio in attesa di pubblicazione su The Astrophysical Journal (questo il preprint) suggerisce che per l’Universo “vicino” il valore della costante di Hubble sia di 69,8 km/s/Mpc.

Tutto sommato, confrontando i tre risultati e ricordando che sono stati ottenuti con differenti metodi di analisi, si potrebbe essere indotti a pensare che le discordanze non siano così gravi e le stime possano essere comunque riconciliabili tra di loro. Probabilmente è così, ma nel momento in cui queste stime si confrontano con le conclusioni suggerite dalle osservazioni del satellite Plank (e, prima ancora, del satellite WMAP) la situazione diventa piuttosto preoccupante.

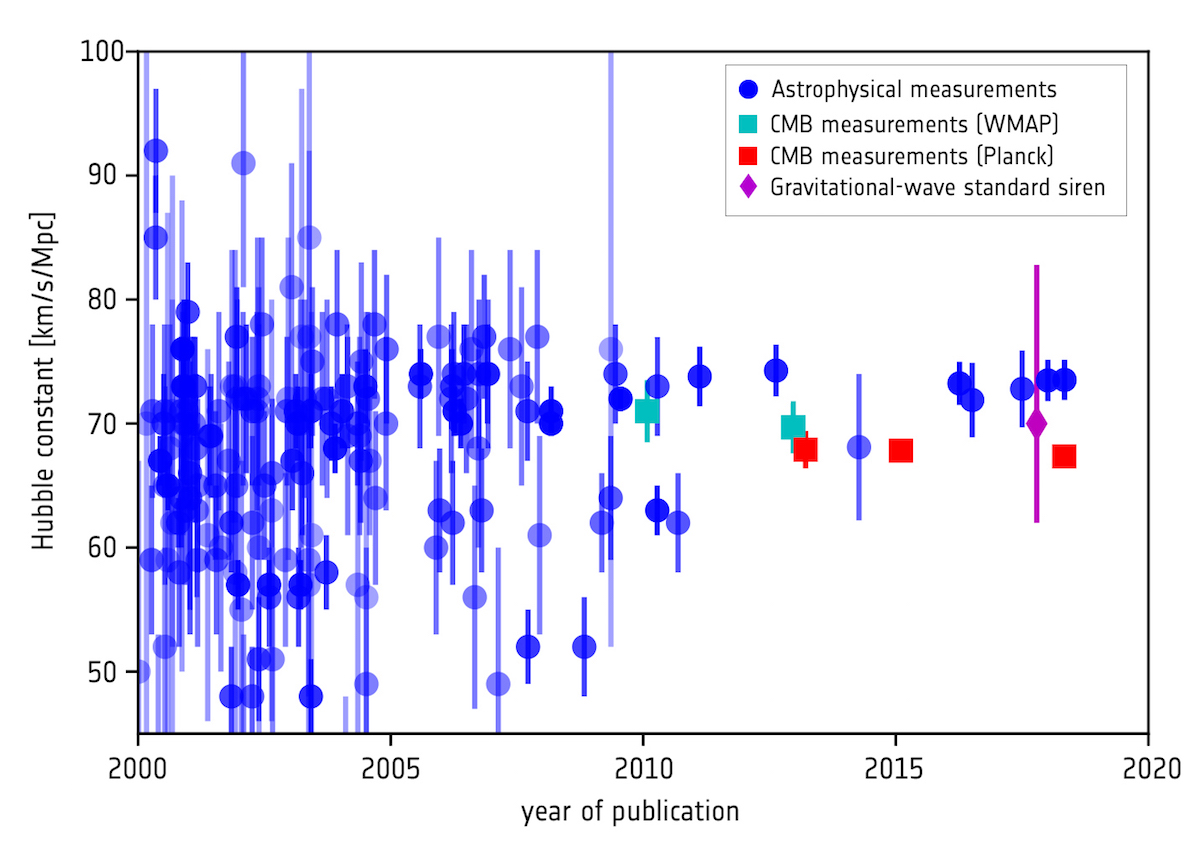

Evoluzione delle stime della costante di Hubble negli ultimi due decenni. A partire dal 2010, alle misure astrofisiche (con margini d’errore sempre più piccoli) si sono affiancate anche le stime provenienti dall’analisi del fondo cosmico a microonde grazie ai satelliti WMAP e Planck. Nel grafico è stato inserito anche il valore ottenuto lo scorso anno osservando le onde gravitazionali generate dalla fusione di due stelle di neutroni (metodo detto delle “sirene standard”). Crediti: ESA/Planck Collaboration

La cosmologia dopo Planck

Il compito del satellite europeo Planck, lanciato nel maggio 2009, era quello di misurare le caratteristiche della radiazione cosmica di fondo (CMB, Cosmic Microwave Background), una sorta di impronta fossile in grado di mostrarci la situazione in cui si trovava l’Universo 380 mila anni dopo il Big Bang. La missione era una logica continuazione e un notevole miglioramento del lavoro osservativo compiuto dal satellite WMAP (Wilkinson Microwave Anisotropy Probe) lanciato otto anni prima dalla NASA. La precisione dei dati raccolti da Planck – i suoi sensori erano in grado di rilevare nel fondo a microonde variazioni di temperatura di qualche milionesimo di grado – ha permesso ai cosmologi di costruire un modello accurato dell’Universo, determinandone le proprietà su grande scala e la composizione in termini di materia ordinaria, materia oscura ed energia oscura.

Per raccordare questo modello cosmologico di un Universo neonato con l’Universo attuale è indispensabile fissare il suo ritmo di espansione, cioè definire il valore della costante di Hubble. In linea di principio, mettendo in conto le incertezze che caratterizzano i differenti metodi, il valore di Planck e i valori astrofisici dovrebbero concordare. Ebbene, dal modello di Planck è scaturito un valore di 67,8 km/s/Mpc (successivamente affinato a 67,4 km/s/Mpc), valore molto distante dalle stime ottenute utilizzando metodi astrofisici. Si è dunque creata quella che i cosmologi chiamano una tensione tra le due misure, una strana anomalia della quale ancora non si riesce a comprendere l’origine.

Guardando le ultime misurazioni, questa tensione sembra ormai scivolata verso una preoccupante incompatibilità tra le due stime, una situazione che desta notevole apprensione negli addetti ai lavori. Significativo, a tal proposito, un commento di Adam Riess: «La tensione sembra essere diventata un’incompatibilità completa tra i nostri punti di vista sull’Universo delle origini e quello odierno. A questo punto, chiaramente, non è un semplice errore grossolano in una qualsiasi misura. È come se avessi previsto quanto sarebbe stato alto un bambino da una tabella di crescita e poi lo avessi trovato superare di molto la previsione da adulto. Siamo molto perplessi».

Dov’è l’errore?

Per provare a chiarire la situazione e ipotizzare alcune vie d’uscita abbiamo chiesto l’aiuto di Amedeo Balbi, cosmologo, docente di astronomia e astrofisica all’Università di Roma “Tor Vergata” e noto divulgatore.

Dottor Balbi, qual è il significato e l’importanza della costante di Hubble nell’attuale cosmologia? Perché è così importante conoscere il suo valore con la massima precisione? Che differenza può fare una manciata di km/s/Mpc in più o in meno?

È un parametro fondamentale. Conoscerlo influenza quasi ogni altra quantità che descrive l’Universo, dalla sua età, al contenuto di materia ed energia, alle distanze, e così via. Quindi è molto importante conoscerlo con la massima precisione. La cosmologia, in questo senso, è cambiata moltissimo rispetto a qualche decennio fa, quando l’incertezza sulla costante di Hubble era enorme, e ogni altro parametro era affetto da questa incertezza. Apparentemente, grazie a continui affinamenti, entrambi i metodi di stima (astrofisico e cosmologico) sembrano aver raggiunto i limiti massimi delle loro precisioni.

È proprio così o potrebbero esserci ancora margini di aggiustamento/miglioramento? In altre parole, l’attuale divario tra i valori della costante di Hubble indicati da Planck e dalla recessione delle galassie è in qualche modo definitivo?

Non sarei così categorico. È vero che le incertezze sono molto diminuite negli ultimi anni, e che almeno nel caso del metodo cosmologico basato sull’osservazione della radiazione cosmica di fondo siamo praticamente al limite teoriche di incertezza. Ma bisogna tenere presente che potrebbero esserci incertezze sistematiche che non abbiamo identificato, e che potrebbero spiegare la discrepanza. Quindi direi che ci sono ancora margini di miglioramento in futuro.

Inevitabile chiederle quali potrebbero essere le vie d’uscita da questa situazione piuttosto anomala. Secondo lei, la soluzione verrà dall’individuare quale dei due metodi è affetto da errore oppure, più drasticamente, si dovrà cominciare a pensare a nuovi scenari, magari arrivando persino a rivoluzionare l’attuale fisica?

Come dicevo, penso che sia del tutto possibile che ci siano incertezze ancora non identificate nelle misure. L’alternativa è che si debba modificare il modello cosmologico, anche se in questo caso non arriverei a parlare di rivoluzione. A ogni modo, direi che per il momento non c’è nessuna evidenza che indichi che sia necessario intervenire sulla teoria che conosciamo. Se dovessi scommettere, direi che verrà fuori che il problema è nelle misure: mi sembra la soluzione più semplice. Ma, come al solito, vedremo dove ci porteranno i dati.

Alcuni hanno sottolineato come l’affinarsi della rilevazione delle onde gravitazionali e i recenti exploit dell’astronomia multi-messaggero potranno dimostrarsi cruciali anche nel caso della determinazione della costante di Hubble. Qual è la sua opinione? In quale modo le onde gravitazionali potrebbero dire la loro?

Certo, le onde gravitazionali sono un nuovo strumento nella cassetta degli attrezzi dei cosmologi e una delle cose che possono fare è proprio aiutarci a determinare la costante di Hubble in maniera indipendente da altre osservazioni. Il metodo è già stato applicato recentemente, e si basa sull’osservazione delle cosiddette “sirene standard”: quando due oggetti compatti (ad esempio due stelle di neutroni) ruotano attorno a loro finendo per collidere, le onde gravitazionali prodotte esibiscono una variazione di frequenza che dipende dalla loro distanza da noi e che quindi permette, se sappiamo anche il redshift della galassia che ospita il fenomeno, di misurare la costante di Hubble. Per ora questo metodo dà risultati compatibili con quelli ottenuti con il metodo tradizionale delle “candele standard”. Ma in futuro questo tipo di osservazioni combinate potrà forse dare una mano a risolvere il problema.