Il dibattito pubblico sull'intelligenza artificiale tende a essere sempre più polarizzato. Due libri di recente pubblicazione, ancora non tradotti in italiano, possono aiutare ad andare oltre tale polarizzazione: sono Artificial Intelligence. A Guide for Thinking Humans, di Melanie Mitchell (Pelican, 2020) e The Road to Conscious Machines The Story of AI, di Michael Wooldridge (Pelican, 2021). La recensione di Hykel Hosni.

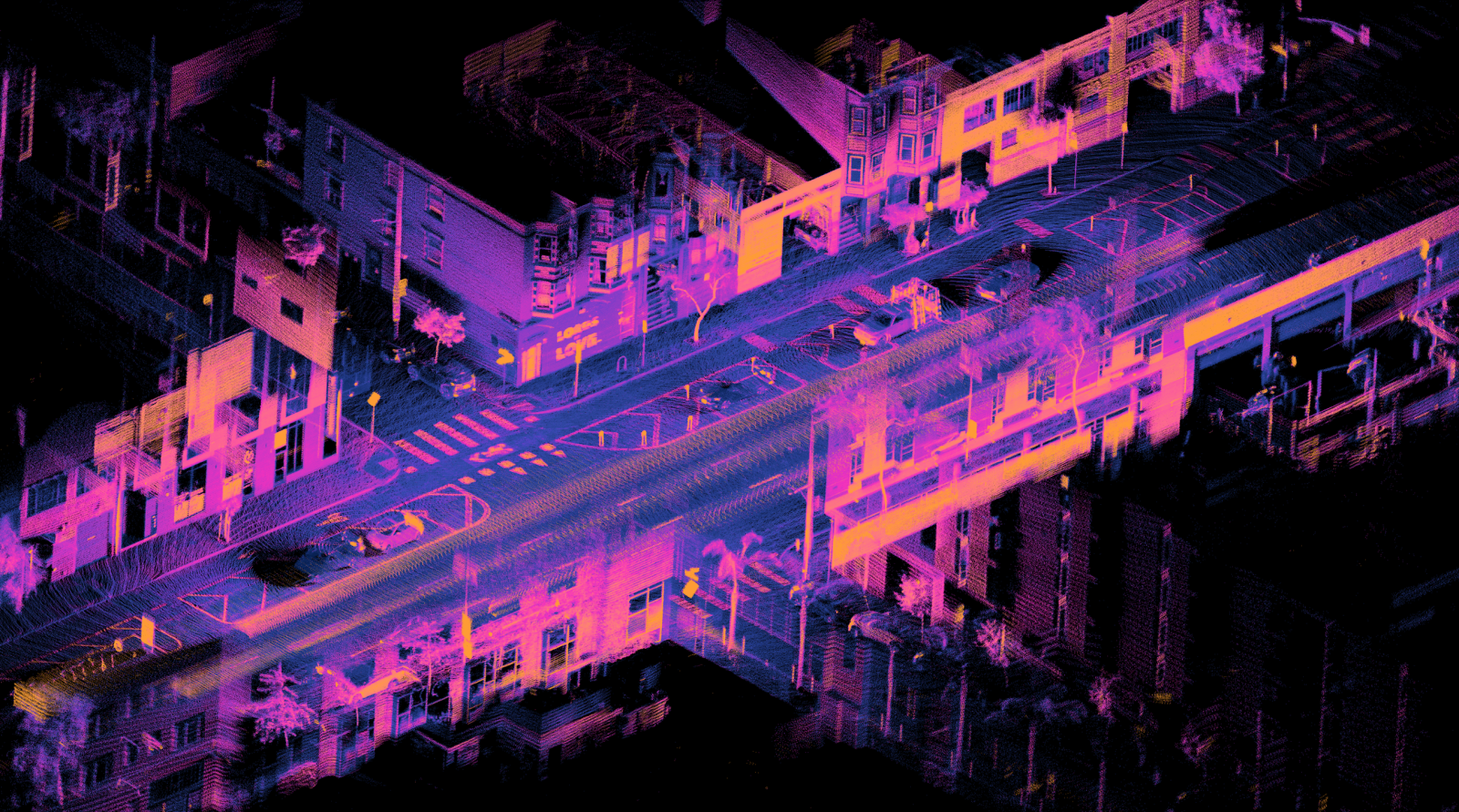

Nell'immagine: Una strada di San Francisco catturata tramite lidar, (un sistema basato sul laser per stabilire la distanza degli oggetti) montato su una auto a guida autonoma in movimento. Crediti: Daniel L. Lu/Wikimedia Commons. Licenza: CC BY 4.0

L'intelligenza artificiale ci riguarda. A chi fa ricerca offre opportunità senza precedenti, in primo luogo in biologia e medicina. Alle imprese offre opportunità di sviluppo che, secondo opinioni sempre più comuni, sono analoghe a quello permesso dall'invenzione della macchina a vapore. Alla società, infine, offre la possibilità di beneficiare universalmente e direttamente, e su una scala prima mai osservata, di tutti questi progressi. Il sistema universitario italiano si sta rapidamente attrezzando per far fronte al repentino incremento della domanda professionale in questo ambito, e per garantire a questo settore uno sviluppo tecnico-scientifico di medio periodo. Così in pochi anni sono stati inaugurati corsi di studio a vocazione multidisciplinare e internazionale in intelligenza artificiale, mentre da pochi giorni sono scaduti i termini per presentare le candidature al primo anno del dottorato nazionale in intelligenza artificiale.

Il grande impatto sociale di ciascuna delle opportunità sopra menzionate e i pericoli associati hanno polarizzato sempre di più il dibattito pubblico intorno all’intelligenza artificiale, che spesso si articola in posizioni acritiche fatte da un lato di eccessi di entusiasmo per la tecnologia che promette di risolvere tutti i problemi scientifici, sociali e umani d'un sol colpo, e dall'altro di un corrispondente e marcato disfattismo luddista. Va da sé che le vere opportunità di progresso, così come la comprensione adeguata dei rischi associati, vadano cercate nel mezzo. Ma cosa ci sia nel mezzo, non è sempre facile da capire.

Fortunatamente due saggi di recente pubblicazione sono a disposizione di chi volesse andare oltre la polarizzazione. Si tratta di Artificial Intelligence. A Guide for Thinking Humans, di Melanie Mitchell (Pelican, 2020, 448 pagine) e The Road to Conscious Machines The Story of AI, di Michael Wooldridge (Pelican, 2021, 416 pagine).

Consiglio la lettura di entrambi non perché incarnino (le) due fazioni antagoniste. Tutt'altro. Si tratta di saggi scritti con cura da persone autorevoli, ma che affrontano l’argomento con tagli distinti. In entrambi i casi il lavoro editoriale è pregevole e questo rende accessibile, a chiunque legga con attenzione, il nocciolo della questione che riguarda appunto lo stato di fatto relativo alle opportunità scientifico-economiche e i pericoli sociali connessi all'intelligenza artificiale.

La pluralità dei punti di vista è una condizione fondamentale per la comprensione dell'intelligenza artificiale che, come mostrato dagli autori, resiste fortunatamente a qualsiasi tentativo di definizione. Anzi, entrambi prestano attenzione a ricordare come la scelta dell'espressione intelligenza artificiale fosse stata considerata insoddisfacente dal suo stesso proponente, il matematico (di formazione) John McCarthy, che al proposito ha chiosato «un qualche nome dovevamo pur darglielo». In quel plurale è compreso anche Claude Shannon, figura più nota e co-organizzatore della scuola estiva di Dartmouth del 1956, considerata l’atto di nascita ufficiale dell'intelligenza artificiale – anche se come ricorda Wooldridge in apertura, l'articolo Computing Machinery and Intelligence, pubblicato nel 1950 da Alan Mathison Turing, è senza dubbio la prima riflessione programmatica sul tema dell’intelligenza meccanica.

Il taglio di Wooldridge è esplicitamente storico. L'autore proviene dalla tradizione logica dell'intelligenza artificiale, di cui racconta il lungo inverno con un'interessante commistione di autocritica e nostalgia. Comprensibile per chi ha avviato la propria carriera in un'area di ricerca di cui ha rapidamente compreso l'irrealizzabilità delle aspettative alimentate dell'overstatement dei suoi promotori scientifici, e della politica che per motivi vari, in vari momenti, si è dimostrata sensibile a quell'eccesso di ottimismo. Ma come succede in tutti gli ambiti, eccedere nelle aspettative è il modo più sicuro di costruire il fallimento.

La storia dell'intelligenza artificiale (IA) è infatti punteggiata di lunghi inverni, seguiti da periodi di repentine riprese di interesse (e finanziamenti), motivate da successi spesso insperati – le primavere dell'IA. L'ultima di queste ha avuto inizio pochi anni fa, quando si sono presentate simultaneamente due tipi di condizioni: la diffusione (quasi) universale di Internet e la disponibilità di processori grafici capaci di elaborare una mole di dati senza precedenti a una velocità senza precedenti. In questo contesto, un'idea che molti alla fine del ventesimo secolo consideravano ormai chiaramente infeconda, ha dato avvio alla prima stagione in cui molte promesse vengono rapidamente mantenute. L’idea in questione è quella delle reti neurali, lo strumento di punta della tecnologia di apprendimento meccanico (machine learning). Non sorprende quindi che entrambi i volumi dedichino ampio spazio a illustrarla, e non sorprende che questi siano i capitoli in cui la lettura richiede maggior impegno che, in entrambi i casi, sarà molto ben ripagato.

Una differenza importante tra i due volumi si osserva nel confronto tra intelligenza artificiale e intelligenza umana. Come indica il sottotitolo, questo è il taglio scelto da Melanie Mitchell, autorevole esponente dell'impostazione cognitivista in intelligenza artificiale. Qui si prende sul serio l'obiettivo di creare sistemi computazionali capaci di attribuire significati paragonabili a quelli umani agli aspetti rilevanti del mondo. Questo mette al centro della discussione la (mancanza di) comprensione che caratterizza anche i più straordinari, e fino a pochi anni fa impensabili, traguardi raggiunti dall'apprendimento meccanico. Mitchell dedica pagine molto appassionate a illustrare le ragioni secondo le quali le tecniche attuali non ci permettono di considerarci vicini ad aver risolto il problema dei "significati": dai significati linguistici alla comprensione di livello umano delle immagini.

Entrambi i volumi aiutano a cogliere un punto certamente sottile: i successi della nuova primavera dell'intelligenza artificiale, per quanto sorprendenti, sono parziali, nel senso di essere confinati a problemi specifici. Se pensiamo all'intelligenza artificiale come disciplina scientifica, non c'è alcuna notizia in questo – le soluzioni scientifiche tendono spesso a essere locali e migliorabili. Le cose cambiano radicalmente se consideriamo le applicazioni di questi sistemi ‘imperfetti’ in ambiti distinti dalla ricerca, di cui gli algoritmi utilizzati in ambito medico e le automobili a guida autonoma costituiscono due esempi particolarmente rilevanti.

Wooldridge dedica una riflessione molto interessante alle prime, le applicazioni mediche, partendo da una battuta di Geoffrey Hinton a cui si deve l'idea originale della tecnologia nota come convolutional neural network e che ha dato luogo a risultati eccellenti nella classificazione delle immagini. Durante una lezione (in un ospedale) nel 2016, Hinton ha paragonato le persone impiegate in radiologia a Willy il Coyote sull'orlo del precipizio prima di aver guardato giù. A questa immagine popolare ha aggiunto una frase che continua oggi ad agitare gli animi «dovremmo smettere di formare persone in radiologia». La provocazione è chiara: i sistemi di apprendimento automatico garantiscono già ora prestazioni superiori a quelle umane, dunque perché perseverare in una linea di formazione subottimale?

Il motivo è ben illustrato da Wooldridge nel caso particolare, e più in generale da Mitchell, e consiste nella fragilità della tecnologia rispetto agli attacchi cosiddetti contraddittori (adversarial). In uno scenario ipotetico in cui la diagnostica per immagini fosse affidata ad algoritmi di apprendimento automatico, si creerebbe un incentivo alla modifica strategica delle immagini in modo tale da indurre il sistema in errore, magari a vantaggio di società private di assicurazione sanitaria o collaborazioni pubblico-privato.

Problemi analoghi emergono con i veicoli autonomi: è molto facile sabotare i segnali stradali per indurre i sistemi di navigazione automatica in errori potenzialmente fatali. Lo schema che emerge è dunque il seguente: se il riconoscimento algoritmico di immagini è uno dei motivi per cui l'intelligenza artificiale sta vivendo una nuova ed economicamente molto florida primavera, l'applicazione di questa tecnologia nel mondo reale rivela limiti e pericoli che a oggi non abbiamo ancora modo di quantificare.

Per farlo è fondamentale evitare l'effetto-Frankenstein. Wooldridge affronta senza particolare understatement la questione, molto gradita a certi canali di comunicazione, della cosiddetta singolarità, cioè l'avvento di una superintelligenza che rapidamente porterà a distruzione il genere umano. La sezione dedicata al tema ha un titolo che non lascia adito a dubbi: "The singularity is bullshit" (La singolarità è una cazzata). Piuttosto che la minaccia di una superintelligenza, Mitchell è preoccupata di fenomeni già molto diffusi, come quello dei deep fake con cui diffondere, molto rapidamente e globalmente, contenuti falsi praticamente indistinguibili da quelli genuini. L'intelligenza artificiale in questo senso non pone problemi etici radicalmente nuovi, ma mette i principi etici e, in modo ancora più diretto, quelli giuridici davanti a nuove sfide tecnologiche. Ma ancora una volta stiamo parlando di una tecnologia ancora molto poco compresa. Si pone dunque il problema di raggiungere innanzitutto una comprensione scientifica dello strumento tale da permetterci di regolamentarlo.

Sarebbe auspicabile vedere presto in libreria le traduzioni italiane di questi due saggi. Questo garantirebbe che l’opera di demistificazione dell’intelligenza artificiale che compiono possa raggiungere un pubblico più ampio possibile.